消除人工智能偏见的5个步骤

来源:

在将人工智能引入医疗保健所带来的众多挑战中,也许最紧迫的是算法偏差,其中人工智能系统在其流程中内置了歧视性倾向。

在专栏的杂志自然,马特·库斯纳,博士,计算机科学在伦敦大学学院系副教授约书亚洛夫特斯,博士,在技术,业务部门的助理教授,并在新的统计数据约克大学概述了开发更公平的AI模型的方法。

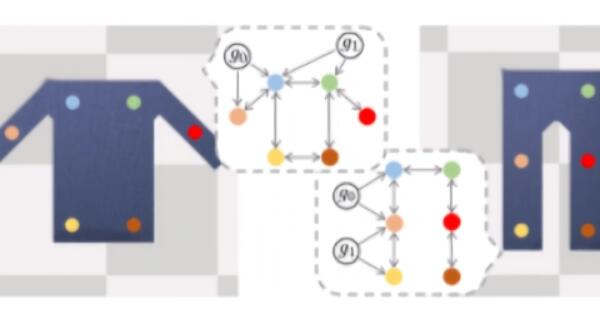

他们写道:“只有找出真正的歧视原因,我们才能建立纠正这些问题的算法。”他认为,“因果模型”是关键,因为它们可以清楚地说明潜在的过程(歧视性或其他形式)来驱动其输出。

选件提供了五项指导原则,以负责任地使用因果模型,并确保它们达到了设计要追求的公正的结果:

1.跨领域合作。

2.与利益相关者合作。

3.使劳动力公平。

4.确定什么时候算法不合适。

5.煽动批评。

作者总结说:“算法越来越多地被用来做出可能改变人们生活的决定。通过使用因果模型来形式化我们对歧视的理解,我们必须构建这些算法来尊重人类决策者所要求的道德标准。”

郑重声明:本文版权归原作者所有,转载文章仅为传播更多信息之目的,如有侵权行为,请第一时间联系我们修改或删除,多谢。