人工智能是一个耗能者我们需要重新考虑其设计

近年来,在一组技术中已经出现了一种说法:人工智能是新的电力。陈词滥调是指人工智能的破坏力,可以推动从交通运输到天气预测的一切进展。

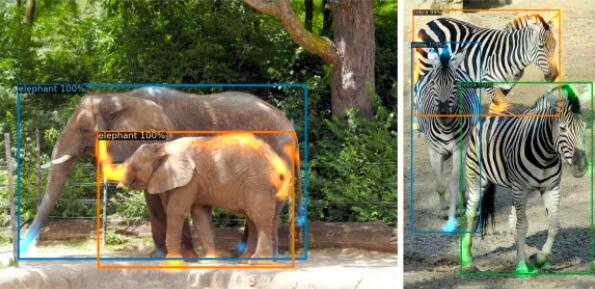

当然,支持AI复杂算法的计算机和数据中心在很大程度上取决于电力。虽然这看起来似乎很明显,但得知AI可能非常耗电,这可能令人惊讶,特别是在训练模型时,使机器能够识别照片中的人脸或让Alexa理解语音命令。

问题的规模难以衡量,但是已经进行了一些尝试,以大笔数字计算环境成本。

例如,在开放存取存储库arXiv上发表的一篇论文声称,用于训练基本自然语言处理(NLP)模型(处理和理解基于语言的数据的算法)的碳排放量等于普通美国人产生的二氧化碳。两年以上的生活方式。一个更强大的模型需要相当于约17年的排放量。

作者指出,大约十年前,NLP模型可以在常规的商用笔记本电脑上完成这项工作。如今,更复杂的AI模型使用诸如图形处理单元或GPU之类的专用硬件,GPU被Nvidia普及用于游戏,该技术也证明能够支持AI的计算任务。

由技术先知和奸商埃隆·马斯克(Elon Musk)共同创立的非营利研究组织OpenAI表示,自2012年以来,“用于最大规模的AI培训运行的计算能力呈指数增长,翻了3.4个月”。 GPU开始进入AI计算系统。

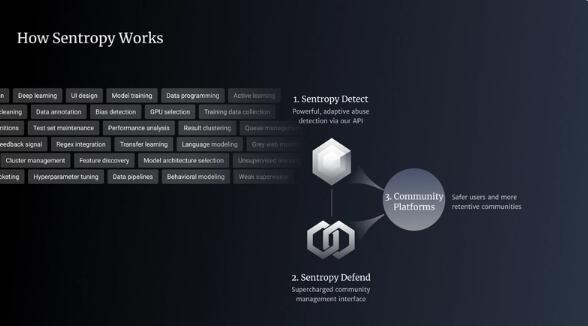

更加智能地了解AI芯片设计

虽然Nvidia的GPU仍是当今AI硬件的金标准,但已经出现了许多初创公司来挑战该公司的行业主导地位。许多人正在构建芯片组,这些芯片组旨在更像人的大脑那样工作,该领域被称为神经形态计算。

Graphcore是这个领域的领先公司之一,这是一家英国初创公司,已筹集了超过4.5亿美元的资金,并拥有19.5亿美元的估值。该公司的GPU版本是IPU,代表情报处理单元。

为了建立更类似于人类的计算机大脑,Graphcore的大脑绕过了常规微处理器所特有的精确但费时的数字运算,而这种运算只能满足于不太精确的算法。

结果本质上是相同的,但是IPU可以更快地完成工作。Graphcore声称它能够在短短56个小时内训练流行的BERT NLP模型,同时使吞吐量提高了三倍,并将延迟减少了20%。

彭博社的一篇文章将这种方法与“人的大脑从计算餐馆的精确GPS坐标转变为只记住餐馆的名称和附近地区”进行了比较。

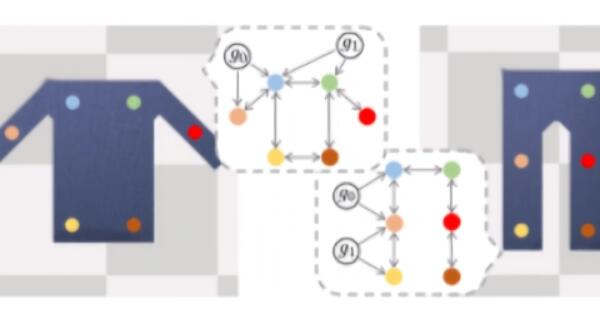

Graphcore的硬件体系结构还具有更多的内置内存处理功能,从而提高了效率,因为不需要在芯片之间来回发送尽可能多的数据。这类似于意大利的一个研究人员小组最近采用的方法,该方法发表了一篇有关新型计算电路的论文。

这种新颖的电路使用一种称为忆阻器的设备,该设备只需执行一次操作即可执行称为回归的数学函数。该方法试图通过直接在内存中处理数据来模仿人脑。

《科学进步》论文的合著者,米兰理工大学的Daniele Ielmini告诉奇点中心,内存计算的主要优势是无需进行任何数据移动,这是常规数字计算机以及数字计算机的主要瓶颈。数据的并行处理使内存阵列中各种电流和电压之间的紧密相互作用成为可能。

Ielmini解释说,内存计算可能“对AI的能效产生巨大影响,因为它可以通过存储电路内的物理计算来加速非常高级的任务。”他补充说,硬件设计需要这种“激进的想法”,以实现能源效率和时间上的飞跃。