人工智能的杰出新应用似乎以越来越高的频率成为头条新闻

无论是为癌症患者提供更快,更准确的诊断,还是为濒临灭绝的动物物种开展保护工作,AI的用途都在不断扩大,并且影响力也越来越大。

除了引人注目的技术进步外,这些示例也很重要,因为它们有助于提高公众对AI的接受度和信任度。这些重要的积极故事与某些媒体发布的负面新闻背道而驰。

就上下文而言,将AI从某些方面接收的接收结果与对其他现在熟悉的技术的历史响应进行比较很有帮助。在成为主流之前,这些例子中的许多受到了相似程度的审查。手机就是一个很好的例子。

人工智能非常强大,因此,应像对待任何新技术一样接受审查和制衡。可以说,该技术具有世界性的变化潜力,因此,对健康的怀疑程度甚至比早期的当今技术更为重要。

例如,很多讨论围绕AI和机器学习(ML)平台继承了我们的人为偏见这一事实,这通常是由于人为选择使用的特定数据做出的决定。甚至这个决定也会显示出有意识或无意识的偏见。这是个问题。例如,我们不想以对某些种族或社会经济群体表现出偏见的刑事司法系统作为结局,因为它们在历史上可能在司法系统中代表过多。我们不希望基于历史估计数的系统能够使女性的工资不平等长期存在,基于人工智能的系统也不应通过在确定健康保险费时将其视为某些疾病的较高风险来歧视那些较不富裕社区的人们。

人工智能驱动的未来应该带来积极的进步,而不是进一步加深现有的偏见和不平等。人们一直在讨论喜剧如何避免“压低”,而避开那些可能已经在日常生活中被边缘化的软目标。以同样的方式,人工智能不应使处境不利者的本已艰难的生活更加艰难。

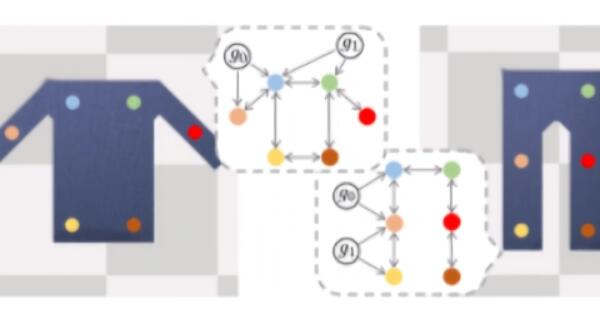

为了消除AI和ML的偏见,在基于此技术设计产品时,我们需要仔细考虑我们的意图。我们必须小心,不要基于用于训练它们的数据集将人为有意或无意识的偏见植入产品中,我们需要从警告中学习而不是重复这些失败。透明度也至关重要。从黑匣子出来的决策(没有显示出他们如何得出特定的决策)可能是有缺陷的,并且容易产生偏差。对于影响人类生活的领域,我们需要能够考虑和检查数据如何流经系统以及如何做出决策。

对于AI专家和数据科学家而言,这是文化上的挑战。过去,科学家和产品设计师能够依靠其令人印象深刻的解决问题能力,而无需精确说明解决方案的工作原理。在当今的AI和机器学习中,所讨论的系统通常是如此复杂,以至于即使是另一位专家也可能无法确定为什么产品决定采用解决方案A而不是回答B,C或D或其他可能结果的整个领域。

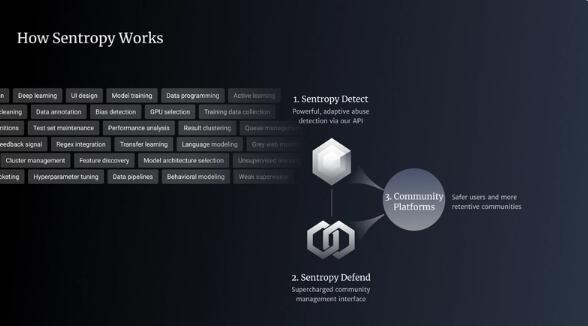

当这些决策涉及对患者的健康诊断或确定您是否可以开设银行帐户或搭乘航班时,创建这些系统的人员和公司必须能够解释这些决策背后的逻辑。在这一点上,社会根据当前的社会和文化习俗来决定制度和结果是否可以接受。正是这种透明导致问责制,进而导致每个人的决策更加公平。

同样,我们还必须对AI和ML进行制衡,而这些制衡和传统的决策系统一样,绝大部分都不是基于规则的。我们需要考虑哪些人被这些系统忽略,服务不足或被抛在后面。考虑到如果只有5%,那么95%的精度还不够好。设计AI系统时,问问自己谁会输。