为什么人工智能对女性有偏见

几年前,亚马逊采用了一种新的自动化招聘工具来审查求职者的简历。推出后不久,该公司意识到技术职位的简历被降级了,其中包括“女性”一词(例如“女子国际象棋俱乐部队长”)或包含女性学院的参考。之所以如此,原因在于用来教授亚马逊系统的数据。基于向公司提交的10年主要男性履历,“新”自动化系统实际上使“旧”情况永久存在,给那些更“熟悉”的申请人打分。

AI4ALL将AI(人工智能)定义为允许计算机做出预测和决策以解决问题的计算机科学分支,从医学的进步到语言翻译应用程序,人工智能(AI)已经对世界产生了影响。但是,正如亚马逊的招聘工具所示,我们教会计算机进行这些选择的方法(称为机器学习)对它们功能的公平性具有真正的影响。

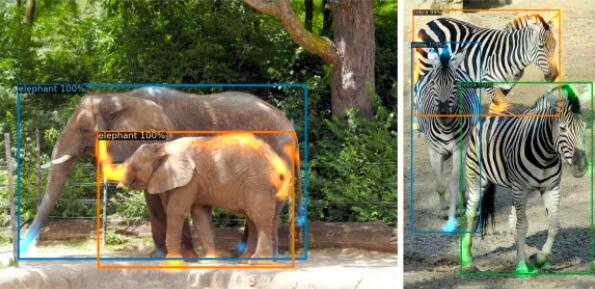

再举一个例子,这次是面部识别。麻省理工学院的代码诗人Joy Buolamwini和GoogleTimnit Gebru的AI伦理研究科学家进行了一项名为“性别阴影”的联合研究,根据他们精心挑选的数据集评估了三种商业性别分类视觉系统。他们发现肤色较黑的女性是分类最错误的群体,错误率高达34.7%,而肤色较浅的男性的最大错误率为0.8%。

随着诸如面部识别工具之类的AI系统开始渗透到社会的许多领域,例如执法领域,分类错误的后果可能是毁灭性的。使用的软件中的错误可能导致对嫌疑犯的错误识别,并最终意味着他们被错误地指控为犯罪。

为了结束许多AI系统中存在的有害歧视,我们需要回顾系统从中学习的数据,这在许多方面都反映了社会中存在的偏见。

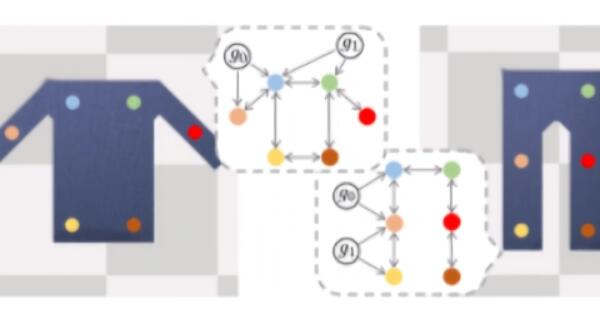

早在2016年,一个团队就研究了词嵌入的用法,该词嵌入充当机器学习中词义和关系的各种词典。他们使用Google新闻文章中的数据训练了一个类比生成器,以创建单词关联。例如,“男人是国王,女人是x”,系统用王后填充。但是当面对“男人是计算机程序员,女人是x”的案例时,选择了“家庭主妇”这个词。

其他类似男女的比喻,例如“护士给外科医生”,也表明单词嵌入包含一些偏见,这些偏见反映了更广泛的社会(以及数据集)中存在的性别定型观念。但是,“由于其广泛的传播使用的基本特征,文字的嵌入不仅反映这种刻板印象,但也可以放大这些,”作者写道。

AI机器本身也永久存在有害的定型观念。诸如Siri,Alexa和Cortana之类的女性性别虚拟个人助理已被指控复制关于女性顺从和次于男性的角色的规范性假设。他们对提示性问题的程序化回应进一步促进了这一点。